Administrateur Systemes & Réseau

Nom: KOUAKOU GUILLAUME Sexe: Masculin

Formation : Titulaire d’un baccalauréat en série D, d’un diplôme de Brevet de Technicien Supérieur en Réseau Informatique et Telecom.

Expérience professionnelle :Administrateur Systemes et Réseau a EBENYX TECHNOLOGIES depuis avril 2020

Compétences : Maitrise des systèmes d’exploitation Linux (CentOS, Debian, Ubuntu, Red Hat, Oracle Linux, etc), Des outils de virtualisation tels que : VMWare, HYPER-V, Proxmox et de bonne connaissance en intégration et base de donnée (PostgreSQL)

Docker, plateforme de conteneur Linux

Le terme « Docker » désigne plusieurs choses : le projet d’une communauté Open Source, les outils issus de ce projet Open Source, l’entreprise Docker Inc. qui constitue le principal soutien de ce projet, ainsi que les outils que l’entreprise prend officiellement en charge. Des technologies et une entreprise qui partagent le même nom, cela peut prêter à confusion. Voici donc une rapide explication de cet état de fait.

- Le logiciel « Docker » est une technologie de conteneurisation qui permet la création et l’utilisation de conteneur Linux.

- La communauté Open Source Docker travaille à l’amélioration de cette La communauté Open Source Docker travaille à l’amélioration de cette technologie disponible gratuitement pour tout le monde.

- L’entreprise Docker Inc. s’appuie sur le travail de la communauté Docker, sécurise sa technologie et partage ses avancées avec tous les utilisateurs. Elle prend ensuite en charge les technologies améliorées et sécurisées pour ses clients professionnels.

A quoi sert Docker ?

Avec la technologie Docker, vous pouvez traiter les conteneurs comme des machines virtuelles très légères et modulaires. En outre, ces conteneurs vous offrent une grande flexibilité : vous pouvez les créer, déployer, copier et déplacer d’un environnement à un autre, ce qui vous permet d’optimiser vos applications pour le cloud.

Comment fonctionne la technologie Docker ?

La technologie Docker utilise le noyau Linux et des fonctions de ce noyau, telles que les groupes de contrôle cgroups et les espaces de noms, pour séparer les processus afin qu’ils puissent s’exécuter de façon indépendante. Cette indépendance reflète l’objectif des conteneurs : exécuter plusieurs processus et applications séparément les uns des autres afin d’optimiser l’utilisation de votre infrastructure tout en bénéficiant du même niveau de sécurité que celui des systèmes distincts. Les outils de conteneurs, y compris Docker, sont associés à un modèle de déploiement basé sur une image. Il est ainsi plus simple de partager une application ou un ensemble de services, avec toutes leurs dépendances, entre plusieurs environnements. Docker permet aussi d’automatiser le déploiement des applications (ou d’ensembles de processus combinés qui forment une application) au sein d’un environnement de conteneurs. Ces outils conçus sur des conteneurs Linux (d’où leur convivialité et leur singularité) offrent aux utilisateurs un accès sans précédent aux applications, la capacité d’accélérer le déploiement, ainsi qu’un contrôle des versions et de l’attribution des versions.

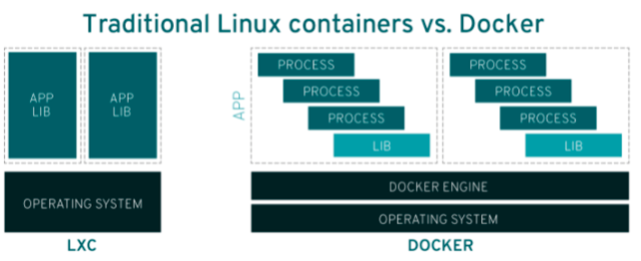

La technologie Docker est-elle la meme que celle des conteneurs Linux traditionnels ?

Non. À l’origine, la technologie Docker a été créée sur la base de la technologie LXC, que la plupart des utilisateurs associent aux conteneurs Linux « traditionnels », mais elle s’est depuis émancipée. LXC était un outil de virtualisation léger très utile, mais il n’offrait pas une expérience à la hauteur pour les utilisateurs ou les développeurs. La technologie Docker permet non seulement d’exécuter des conteneurs, mais aussi de simplifier leur conception et leur fabrication, l’envoi d’images, le contrôle des versions d’image, etc.

Les conteneurs Linux traditionnels utilisent un système init capable de gérer plusieurs processus. Ainsi, des applications entières peuvent s’exécuter comme un bloc. La technologie Docker encourage la décomposition des applications en processus distincts et fournit les outils nécessaires pour y parvenir. Cette approche granulaire présente bien des avantages.

Les avantages des conteneurs Docker

Modularité

L’approche de Docker en matière de conteneurisation repose sur la décomposition des applications : c’est-à-dire la capacité de réparer ou de mettre à jour une partie d’une application sans devoir désactiver l’ensemble de cette dernière. En plus de cette approche basée sur les microservices, Docker vous permet de partager des processus entre différentes applications quasiment comme vous le feriez avec une architecture orientée services (SOA).

Couches et contrôle des versions d’images

Chaque fichier image Docker est composé d’une série de couches. Ces couches sont assemblées dans une image unique. Chaque modification de l’image engendre la création d’une couche. Chaque fois qu’un utilisateur exécute une commande, comme run ou copy, une nouvelle couche se crée. Docker réutilise ces couches pour la construction de nouveaux conteneurs, accélérant ainsi le processus de construction. Les modifications intermédiaires sont partagées entre les images, ce qui optimise la vitesse, la taille et l’efficacité. Qui dit superposition de couches, dit contrôle des versions. À chaque changement, un journal des modifications est mis à jour afin de vous offrir un contrôle total des images de votre conteneur.

Restauration

La fonction la plus intéressante de la superposition de couches est sans doute la restauration. Chaque image est composée de couches. Aussi, si l’itération actuelle d’une image ne vous convient pas, vous pouvez restaurer la version précédente. Cette fonction favorise le développement agile et vous aide à mettre en œuvre les pratiques d’intégration et de déploiement continus (CI/CD) au niveau des outils.

Déploiement rapide

Avant, il fallait plusieurs jours pour mettre en place du nouveau matériel, le faire fonctionner, l’approvisionner et le rendre disponible. C’était un processus complexe et fastidieux. Aujourd’hui, avec les conteneurs Docker, vous pouvez effectuer tout cela en quelques secondes seulement. En créant un conteneur pour chaque processus, vous pouvez rapidement partager les processus similaires avec les nouvelles applications. De plus, comme vous n’avez pas besoin de redémarrer le système d’exploitation pour ajouter ou déplacer un conteneur, le délai de déploiement s’en trouve encore réduit. Et ce n’est pas tout. La vitesse du déploiement est telle que vous pouvez vous permettre de créer et de détruire facilement et à moindre coût les données de vos conteneurs, sans aucun problème. Pour résumer, la technologie Docker propose une approche plus granulaire, contrôlable et basée sur des microservices, qui place l’efficacité au cœur de ses objectifs.

Existe-t-il des limites a l’utilisation de Docker ?

Docker est une technologie très efficace pour la gestion de conteneurs uniques. Cependant, à mesure qu’augmente le nombre de conteneurs et d’applications conteneurisées (tous décomposés en centaines de composants), la gestion et l’orchestration se complexifient. Au final, vous devez prendre du recul et regrouper plusieurs conteneurs pour assurer la distribution des services (réseau, sécurité, télémétrie, etc.) vers tous vos conteneurs. C’est précisément à ce niveau qu’intervient la technologie Kubernetes. Avec Docker, vous ne profitez pas des mêmes fonctionnalités de type UNIX qu’offrent les conteneurs Linux traditionnels, c’est-à-dire que vous ne pouvez notamment pas utiliser de processus tels que cron ou syslog au sein du conteneur, en parallèle de votre application. Il existe aussi des limites au niveau du nettoyage des processus petits-enfants après l’arrêt des processus enfants, alors que ce nettoyage était effectué par les conteneurs Linux traditionnels. Vous pouvez contourner ces problèmes en modifiant le fichier de configuration et en configurant ces fonctions dès le début, même si ce n’est pas immédiatement évident. De plus, il existe d’autres sous-systèmes et périphériques Linux qui n’appartiennent pas à un espace de noms, notamment les périphériques SELinux, cgroups et /dev/sd*. Cela signifie que si un pirate prenait le contrôle de ces sous-systèmes, l’hôte serait compromis. Afin de préserver sa légèreté, le noyau de l’hôte est partagé avec les conteneurs, ce qui ouvre une brèche de sécurité. Ce n’est pas le cas avec les machines virtuelles, car elles sont bien mieux isolées du système hôte. Le démon Docker peut également poser des problèmes de sécurité. Pour utiliser et exécuter des conteneurs Docker, il est conseillé d’utiliser le démon Docker, qui s’exécute en permanence pour la gestion des conteneurs. Le démon Docker nécessite des privilèges root, il est donc important de surveiller l’accès à ces processus, ainsi qu’à leur emplacement. Par exemple, un démon en local est plus difficile à attaquer qu’un démon qui réside dans un emplacement public, comme un serveur Web.

References :

- – https://fr.wikipedia.org/wiki/Docker_(logiciel)

–

https://www.redhat.com/fr/topics/containers/whats-a-linux-container

–

https://access.redhat.com/documentation/en-US/Red_Hat_Enterprise_Linux/7/html/7.0_Release_Notes/sect-Red_Hat_Enterprise_Linux-7.0_Release_Notes-Linux_Containers_with_Docker_Format-Advantages_of_Using_Docker.html

–

https://www.redhat.com/fr/topics/containers/what-is-kubernetes

–

https://opensource.com/business/14/7/docker-security-selinux

–

https://opensource.com/business/14/9/security-for-docker

–

https://www.redhat.com/fr/topics/containers/what-is-docker